2025 yılı itibarıyla üretken yapay zekâ (GenAI), deneysel bir teknolojiden kurumlar için vazgeçilmez bir araç hâline geldi. Artık teknolojinin evrildiği değil, neredeyse ışık hızında dönüştüğü bir çağda yaşıyoruz. Bu dönüşümün merkezinde yer alan GenAI, organizasyonların işleyişini, veri koruma stratejilerini ve inovasyon süreçlerini kökten değiştiriyor. Ancak bu olağanüstü verimlilik potansiyeli, beraberinde karmaşık güvenlik risklerini de getiriyor.

Değerli iş ortağımız Palo Alto Networks’ün hazırladığı “2025’te Üretken Yapay Zekânın Durumu” başlıklı son rapor, dünya genelindeki yedi binden fazla müşteriden elde edilen içgörülerle GenAI’nin yükselişini ve bu yükselişin güvenliğe etkilerini gözler önüne seriyor.

GenAI Artık Geçici Bir Trend Değil: Kritik Bir Altyapı

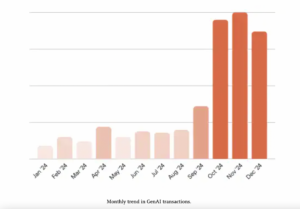

2024 yılında GenAI trafik hacmi %890’dan fazla arttı. Bu artış, Gen AI’ın sadece bir teknolojik heves değil, kurumlar için ölçülebilir verimlilik sağlayan bir altyapı hâline geldiğini gösteriyor. Özellikle Ekim ayındaki ani artış, birçok kurumun GenAI projelerini aktif kullanıma geçirdiğini düşündürüyor. Ancak GenAI uygulamaları, IT ekiplerinin bilgisi ya da onayı olmadan dahi şirket içi kullanıma giriyor; bu da güvenlik tarafında yeni bir risk alanı yaratıyor.

“Shadow AI” Tehlikesi: Veri Sızıntıları Yükselişte

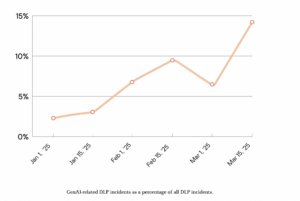

Rapora göre 2025’in başlarında, GenAI kaynaklı veri kaybı olayları (DLP) 2,5 kat artarak SaaS trafiğindeki tüm güvenlik olaylarının %14’ünü oluşturdu. Kurumlar ortalama 66 farklı GenAI uygulaması kullanıyor ve bunların %10’u yüksek riskli kategoride. Onaysız uygulamaların yaygınlığı, açık bir yapay zekâ politikası eksikliği ve hızlı adapte olma baskısı birleştiğinde, kurumsal veriler ciddi şekilde tehlikeye giriyor.

“Shadow AI” olarak adlandırılan bu durum, çalışanların IT izni olmadan AI araçlarını kullanması anlamına geliyor. Bu da hassas verilerin sızması, regülasyonların ihlali ve fikrî mülkiyetin kontrolsüzce paylaşılması risklerini doğuruyor.

Düzenleme Eksikliği ve Artan İş Riski

Düzenleyici otoriteler hızla gelişen yapay zekâ teknolojilerine yetişmeye çalışıyor, fakat bu süreçte oluşan belirsizlik, kurumlar için hem hukuki hem operasyonel riskleri beraberinde getiriyor. Bazı regülasyonlar, kişisel verilerin GenAI araçlarıyla paylaşılmasını ciddi şekilde kısıtlıyor.

Ayrıca denetlenmemiş GenAI araçlarının yanlış çıktılar üretme, oltalama (phishing) girişimlerine zemin hazırlama veya kötü amaçlı yazılımlar içerebilme ihtimali de dikkat çekiyor.

Güvenli GenAI Kullanımı İçin Yol Haritası

Bu karmaşık tabloya rağmen, kurumların GenAI’yi güvenli biçimde benimsemesi mümkün. Palo Alto Networks, kurumlara şu çok katmanlı stratejileri öneriyor:

- Kullanımı analiz et ve sınırlandır: Hangi kullanıcı ve grupların, hangi GenAI platformlarına erişebileceğini belirle.

- Hassas verileri koru: Gerçek zamanlı içerik denetimiyle yetkisiz erişimlerin ve veri sızıntılarının önüne geç.

- Yeni tehditlere karşı savun: Zero Trust mimarisiyle, GenAI üzerinden gelebilecek gelişmiş tehdit ve kötü amaçlı yazılımlara karşı koruma sağla.

Güvenliği Hızlandır, İnovasyonu Yakala

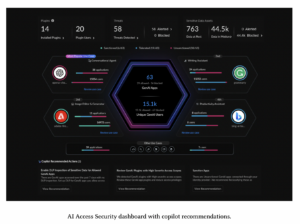

GenAI’nin sunduğu potansiyelden faydalanırken, güvenliği ikinci plana atmamak gerekiyor. Bu sebeple Palo Alto Networks, AI Access Security çözümünü geliştirdi. Bu teknoloji, kurumların üçüncü parti GenAI uygulamalarına güvenli biçimde erişmesini sağlarken, veri sızıntısı ve güvenlik tehditlerini minimize ediyor. Gerçek zamanlı görünürlük, erişim kontrolü, tehdit önleme ve regülasyona uygunluk gibi yetenekler sayesinde, kurumlar GenAI’den maksimum verim alırken güvenlikten ödün vermiyor.

Yapay zekânın geleceği bugünden şekilleniyor. Geride kalmamak ve güvenlik açıklarına maruz kalmamak için, GenAI’nin sunduğu fırsatların yanı sıra getirdiği riskleri de anlamak gerekiyor. Quasys olarak “2025’te Üretken Yapay Zekânın Durumu” raporunu incelemenizi öneriyoruz; akabinde ise güvenli GenAI stratejinizi birlikte oluşturmak için toplantı taleplerinizi bekliyoruz: info@quasys.com.tr